今年度、大学で担当している「教育の方法及び技術(情報通信技術の活用含む)」は、教育と情報・ICTに関する内容を主軸に据えて始まりました。

そして、このタイミングならChatGPTなどのAIチャットを導入しない手はないので、毎回の講義の中でAIチャットを前提とした課題を設けることにしたわけです。

課題名は「訊いて応えて」。

AIやネットに「訊いて」みて、得られた結果について学生本人の意見やコメントで「応えて」いく、という枠組みの連続課題です。

教職を目指している大学生たちがAIチャットを未体験なままに百出している議論を眺めるのではなく、自分たちで使いながらAIのいま現在を見極められるようにしようという趣旨です。

—

利用環境面

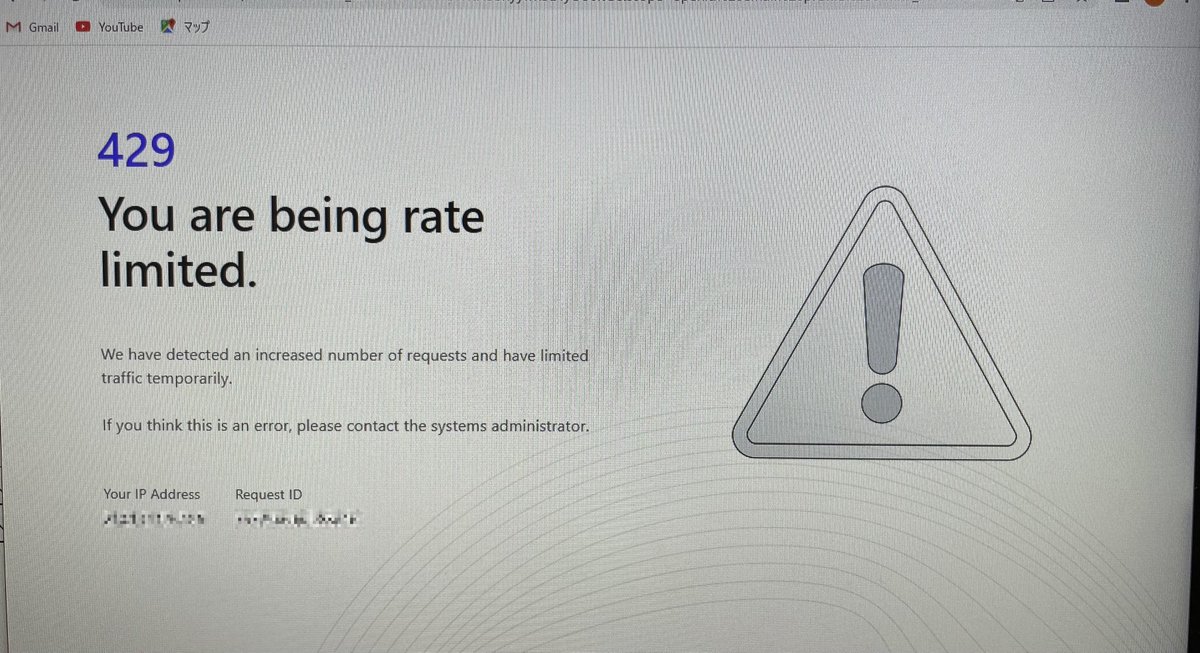

初回、パソコン教室で46名の受講者が一斉にChatGPTにサインアップやログインを試みたところトラブりました。

初回は何人かの学生がこの制限を受けたものの、次週は大丈夫だろうと高を括った2回目もログインすらできない学生が続出。

緊急避難的にChatGPTからPerplexity AIに逃そうとしたものの、しばらくするとそちらも利用のリミットに引っかかって、またお手上げ状態でした。

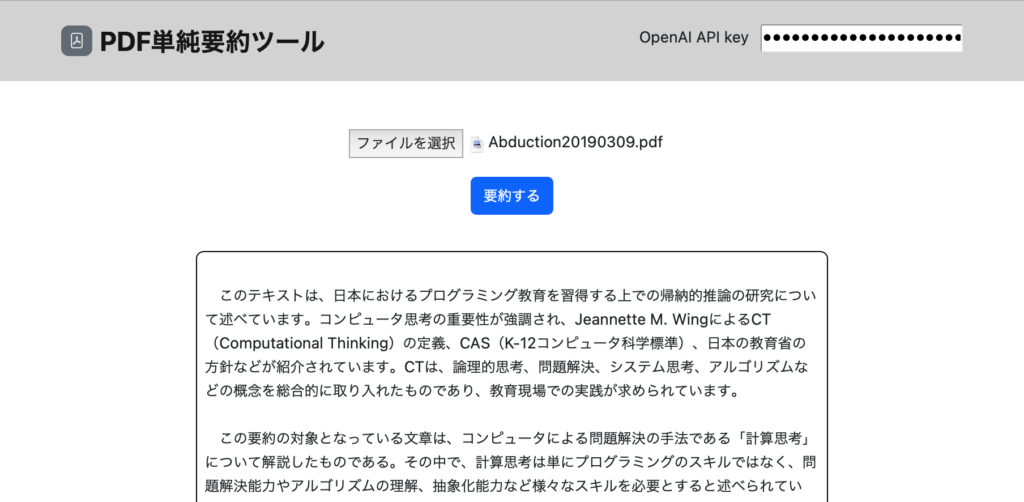

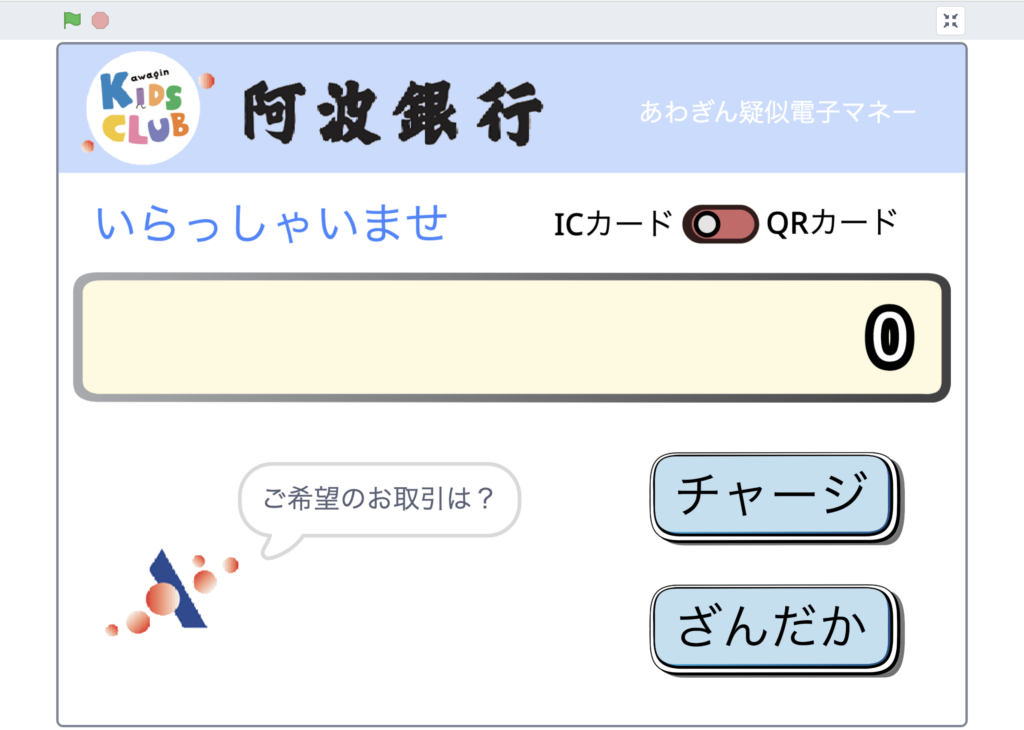

第3回も失敗すると学生の興味関心が極端に薄れてしまう懸念があったため、chatbot-uiをどこかのサーバーに独自に立ち上げて、そこを避難所にする対策をしました。

課題内容面

これまでの「訊いて応えて」ワークは以下の通り。

〈01〉教科書のキーワードを訊いて応えて

〈02〉ニュース記事の数値整理を訊いて応えて

〈03〉対象の比較を箇条書きで訊いて応えて

〈01〉は教科書に掲載されているキーワードから3つほど選んで、AIチャットに訊いてみて、自身のコメントで応える課題でした。

パソコン操作を思い出してもらうことや、ワークの取り組み方を説明するため、課題内容自体は月並みなキーワード調べものです。提出ワークシートはGoogleドキュメントで配布したシートなので、実質作業はコピペ。

それでも、学生達の画面には、「クラスルーム」「授業専用Web資料」「ワークのGoogleドキュメント」「AIチャット」という4種類のウインドウが最低限表示されることになり、これに課題内容によって指定されたリソースがプラスされると、慣れてない学生にとって操作は難解レベルに突入します。

初めのうちは、その状態に慣れてもらうことも織り込んで課題について支援していきます。

ChatGPTなどからのコピペは、単純コピペだとちょっとグレイがかった背景も一緒にペーストされるので、初めのうちはそれを許容しつつ、次第に書式なしペーストなども使えるようになって欲しいという方針です。

それから、自身のコメントで応えていく部分についても、初めは言葉少なですし、賢い学生はAIの出力をそこに貼り付けるといったことも起きますが、そういう取り組みは評価が高くないことも強調して伝えます。結果的にこちらが騙されるレベルに達しているなら、まぁそれはそれでよしとします。

—

〈02〉はニュース記事を使った課題で、文章で紹介された統計数値を表形式にするタスクです。

ちょうど徳島県の人口について紹介したコンパクトなNHKニュースが配信されていたので、この文章をAIチャットに渡して、表形式に変換して見せてくれたら、AIの威力についても感じてもらえるのではないかと思って設定しました。

題材順序として「表形式への変換」は早過ぎでは?とも思いましたが、よい素材と遭遇しましたし、コピペ・テクニックを垣間見せる意味でも、悪くない課題だと判断しました。

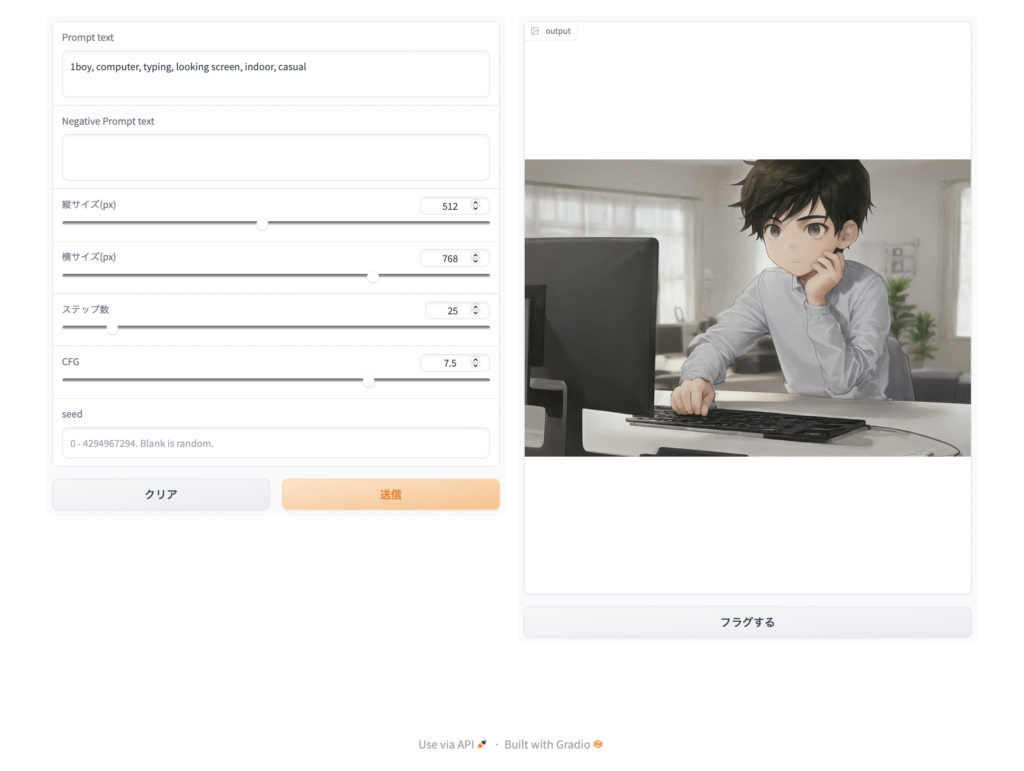

導入のプロンプトとして

次の文章の中の数値を表形式に整理してください:

と入力してもらい、あとは数値が含まれている部分のニュース記事をコピペするだけ。記事をもとにした表が出力される様子を目撃することになります。

しかし、多人数でやっていることで、同じ質問文を入れて同じコピペをしたのに、出力される表の形式が違っていたりすることも見えてくるわけです。さらに、出来上がってくる表も正確性が怪しい。

こうして、AIチャットが常に同じ動作をするわけではないことや、正解を生成するものでもないことを体験して理解していくことになるわけです。最終的には人間の確認も必要だと。

そうした各自が遭遇した事態に応じて、学生自身のコメントを書いてもらうことで課題が完結します。

また、表のコピペも、貼り付けた先でセルの高さが異様に大きいことや背景の色などの諸々を修正していくことが必要になり、細かな修正作業のコツを身につけたり、あるいは表計算アプリ経由でスマートにやる方法へと辿り着く学生がいたりと、多様なパスを支援していく感じになります。

—

〈03〉では、ここまでバタバタと取り組んできたものを一旦立ち止まって振りかえることに注力するため、課題内容自体は、対象の比較を箇条書きにまとめさせたものへ自身のコメントを加えるものにしました。

訊いてコピペして応えていく単純作業。

ただし、「箇条書き」という指定をすることで、どんな出力がなされるのか知って欲しいということ。比較の箇条書きが比較対象個別に出てきたり、比較して分かることをまとめて箇条書きしてくれたり、箇条書きの個数が多すぎたり、といろいろであることを体験し、必要に応じて再回答を指定したり、箇条書きの個数を絞ったりするなど追加の依頼ができるようになることを期待しています。

実際の授業では、前回の表のコピペが思いの外難しかったようなので、そちらを丁寧にフォローすることに時間が割かれました。そのため箇条書きの文章コピペという今回の課題分量は良かったようです。

学生達も、作業段取りについてようやく理解が深まったようで、学生コメントからも今回は自信を持って取り組めた様子が伝わってきました。

また、単にコピペ作業に終わるわけではなく、AIチャットに訊いたことを自身のコメントで応える作業を通して、AIチャットの出力に自分では届かない側面からの視点があって勉強になったという場面もあったようです。作業的な負荷がある程度落ち着けば、課題内容にフォーカスして吟味したり考えたりする余裕が生まれるということなのでしょう。

こんな形でまだ3回しかやっていませんが、AIチャット利用を前提とした「訊いて応えて」ワークを進めているところです。

ワーク課題の作成については自転車操業的にやっているので、この時点でご披露できる将来計画のようなものは残念ながらありませんが、教職志望者がメインの授業ですから、問題作成側の用途に関わるネタも当然入ってくるのかなとは思っています。

今回の授業の技術的条件整備などのお話は、あらためて別のところに書いてみようかと思います。