画像生成系AIの華やかさに比べると、自然言語系AIは貢献の大きさにも関わらず地味な印象でした。

それが昨年末に登場したChatGPTの登場で注目が集ったのはご承知の通りです。

とはいえ、これまでも、私たちが自然言語処理AIの貢献に「おっ!」と思う機会はありました。2019年頃にGoogleがサービス品質が向上のため導入したAI言語モデル「BERT」がもたらした変化でした。

そのときは、Google翻訳の品質が向上したと話題になりました。もっとも翌2020年にはDeepL翻訳が登場して話題をかっさらっていきましたが、こちらもAI技術が活かされたサービスでした。

—

ChatGPTは、OpenAIという研究企業が開発したGPT(Generative Pre-trained Transformer)と呼ばれる自然言語処理向け大規模言語モデルの第三世代「GPT-3」を利用したチャット型の応答システムです。

自然言語処理AIをチャットというインタラクティブな形で一般に提供したこと、加えて外部のプログラムからAI機能を利用できるようにするAPIを提供したこと。このことで大注目を集めることになりました。

インターネットやクラウドサービスなどの基盤となる技術が、広く社会に浸透することで日常生活が大きく変化してきました。これと同じレベルで変化を起こすと目されているのがAI技術であり、それが広く浸透するとどうなるかを垣間見せてくれているのが今回のChatGPTの登場とそれに続くMicrosoftの新しいBingです。

Googleも言語モデルBERTを大幅に改良した「LaMDA」をつくっており、これを利用した会話型AIチャットサービス「Bard」の提供を予定しています。

これまで、自然言語処理AIの言語モデルは、主にGoogle翻訳やDeepL翻訳などに代表される言葉を扱うサービスの裏方技術として陰ながら利用されていたので、存在も地味でした。

ChatGPTは、チャットの形でユーザーとの応答に利用したことで、自然言語処理AIの効果をよりインタラクティブに見せられて分かりやすくなっています。

しかし、報道記事では、当初OpenAIの社員はほとんど誰も評価していなかったサービスだったそうです。玄人と素人でウケるポイントが違ったのかも知れません。一般の人々でも、それまでAIチャットに触れたことがある人ほど、今回も大したことないだろうとタカを括っていたところがあったようです。

ところが公開後、質問と回答といった単純なやりとりだけでなく、問いかけ方次第で様々異なる形で返答さられることが伝わってくると、ChatGPTの潜在威力に気づき始める人が増えていきます。

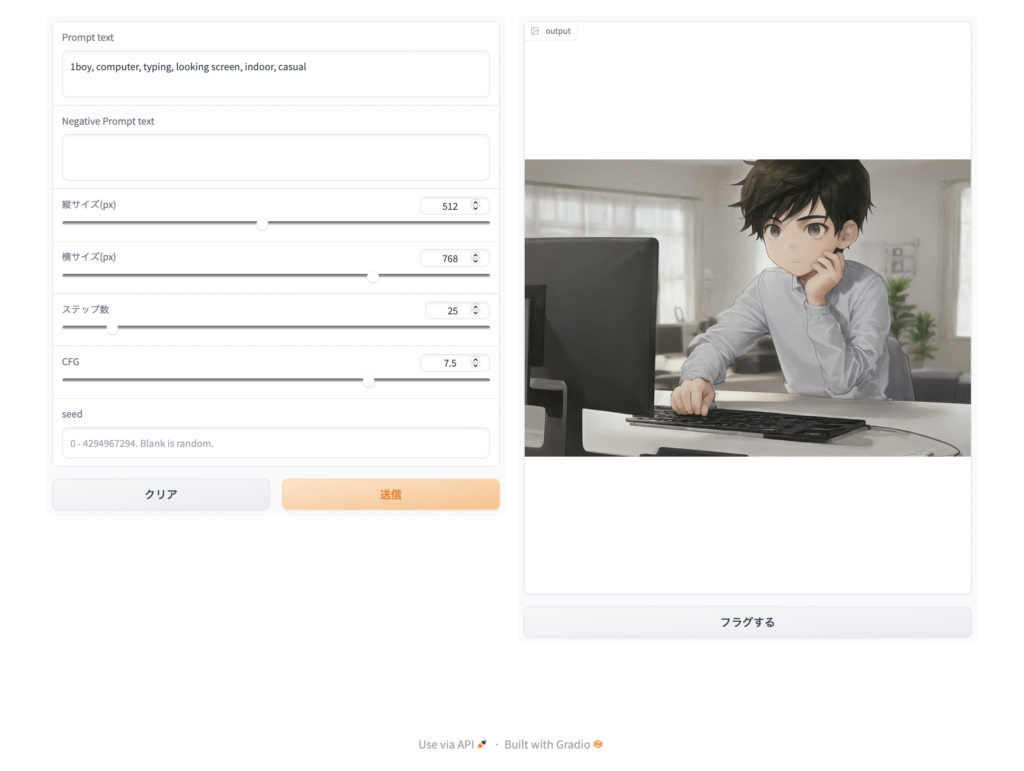

たとえば、テクノロジー系の人々は、ChatGPTがプログラミングコードを書いてくれることに驚きました。目的の処理を明解に記述してから「その処理ができる○○言語のコードを教えて」と書き添えて質問するだけで、サンプルコードを出力してくれるのです。そこから、サンプルデータを生成させたり、プログラムコードを添削させたりできることに驚嘆していきます。

教育関係では、言語教育の先生達がこのChatGPTに最も反応しました。お願いの仕方次第で、英文を生成したり、入力した英文を要約させたり、添削したり、翻訳させたり、単語帳を生成したり、テストの問題を考えさせたりと思いつくことを積極的に投げ掛けて試しています。(報告動画がYouTubeにたくさん上がっています)

2023年の1月は一般メディアもこぞってChatGPTを取り上げて話題にしました。ネット上でも、実に様々な質問を投げ掛けて、多様な返答を誘導しようとする試みが溢れています。

—

その性能に多くの人々が驚嘆すると同時に、懸念の声も高まりました。

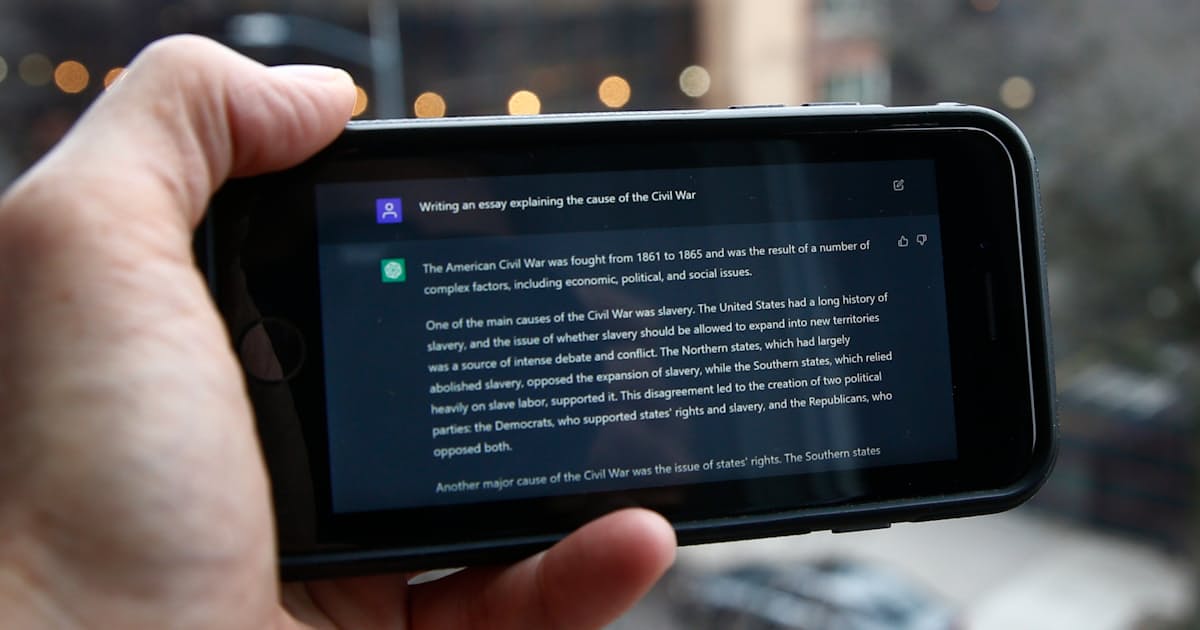

お題をChatGPTに投げ掛けると、簡単なレポートを作成することは朝飯前。

となれば、学校のレポート課題に利用できると誰もが考え、そして実際にそれが起こり、ChatGPTを課題で利用することを禁止するところも出ました。

禁止する流れの一方で容認や可能性の模索も…

これらの記事でも解説されているように、自然言語処理AIは、GPT-3などの大規模言語モデルのおかげで大変自然な文章を生成し返すようになってきましたが、それは「尤もらしく文章生成する」能力に長けているということであって、「正確な内容の文章を生成する」わけではありません。

そのため、ChatGPTは不正確な内容で「息を吐くように嘘をつく」場合もあるのです。

もっとも、ウソというよりもデタラメというのが近いかも知れませんし、もっと言えばデマカセと表現した方がより近いかも知れません。ChatGPTの中のAIは、学習した通りに文章を生成しているだけですから、学習が間違っていたり十分でなかったりすることが、そのまま生成される文章に反映されてしまっているだけ。意図的に嘘をついているわけではないわけです。知ったかぶりを嘘と呼ぶか呼ばないかに近い感じでしょうか。

このような存在しない事実を出力する事態を「ハルシネーション」と呼びます。

いずれにしても、あまりにも「尤もらしく文章を生成する」ことが引き起こす弊害も小さくないわけで、こうした自然言語処理AI技術が生成する成果の利用について、利用者側に相応のリテラシーが求められます。

ChatGPTは公開一週間も経たないうちに登録ユーザーか100万人を超えたとされ、これほど短期間で100万ユーザーを達成したサービスはなかったと話題です。

これに対してGoogleも社内で緊急事態宣言を発したほど衝撃を受けたようです。そもそも自然言語処理AIに関してはGoogleの貢献が大きく、技術的な蓄積も多いと考えられています。そのGoogleが慌てふためいているというのは、技術的な衝撃というよりも、現段階の成熟度で一般公開してしまう無鉄砲さにだろう思います。

玄人であるGoogleにしてみれば、確かに自然言語処理AIによるチャットは尤もらしく返答するし、インパクトはあるのだろうけれど、質問に対する返答の安全性や品質安定をコントロールする最適解が見つかっていない段階で、AIチャットを素のままで提供するリスクは冒せないできたのだと思います。

それを実験サービスとはいえ一般提供してしまったChatGPTの登場は、Googleにしてみれば「おいおい」といった感じだったのでしょう。

その後、ChatGPTをベースとした多様なサービスが雨後の筍のように登場し、2023年2月に入って、いよいよ真打ちが登場するいたって、Googleの焦りはピークに達します。

以前よりOpenAIへの投資や提携を行なっていたMicrosoftが、自社の検索サービス「Bing」にAIチャットを搭載することを発表したのです。

新しいBingは、ChatGPTの言語モデルGPT-3をベースに検索向けに強化された言語モデルPrometheusを採用したと言われています。より賢くなり、検索した最新情報をもとに返答でき、参照した情報のリンクも表示する点がChatGPTと違います。

さらにMicrosoftは、自社のEdgeブラウザやMicrosoft 365等のアプリケーションにもこのAI技術を導入して、様々な場面で自然言語処理AIの助けを借りられるように開発作業を進めています。

一般の人々があらゆる場面でAIチャットを便利に使うことになれば、これまでのネット検索の在り方が変わってしまうわけで、検索サービスの王者Googleにとっては地位が揺らぎかねない事態というわけです。

従来の検索の概念を前提としていた学校教育にとっても、少なからず影響は避けられません。

情報を効率的に扱う方法のひとつとして、自然言語処理AIがもたらす力を利用することは重要です。

その力がもたらす事態をより具体的に体験できるようになったことで、さて、私たちがそもそもやりたかったことは何だろうという根本的な問いに戻らざるを得なくなります。

知識に携わる人々の中では、立ち位置や価値観の違いによって態度の違いが明確になり、より軋轢が増すかも知れません。技術に振り回されることにうんざりする頻度も多くなるかも知れません。

一方で、様々な可能性が拓ける領域も増えていきます。自然言語処理AIは工夫次第で様々な人工物や活動に利便性をもたらします。それを専門家ではない一般の人々が実現できるという点に、いま起こっていることの凄さがあるといえます。